【オセロニア】最強Sキャラ(S駒)ランキングTOP20【最新版】|ゲームエイト

1 実験設定 教師あり学習でも表現学習と同じく2017年1月に集計されたプレイヤーランクが76~200同士の対戦ログを使用した. なお、この決勝大会の全試合の様子を、『逆転オセロニア』公式YouTubeちゃんねるでの生配信でお楽しみいただけます。 連続変数が混ざる場合を含めて 混合整数計画問題 MIP と呼ばれることも多いです。

1 実験設定 教師あり学習でも表現学習と同じく2017年1月に集計されたプレイヤーランクが76~200同士の対戦ログを使用した. なお、この決勝大会の全試合の様子を、『逆転オセロニア』公式YouTubeちゃんねるでの生配信でお楽しみいただけます。 連続変数が混ざる場合を含めて 混合整数計画問題 MIP と呼ばれることも多いです。

キャンペーン AXEと『逆転オセロニア』のコラボレーションを記念し、限定グッズが当たるキャンペーンを開催。

しかし現在の一般に頒布されている最新ゲームにおいては,前述の通りゲーム内容がオンラインに更新されていき,入力情報や出力行動数が増加するなど,レトロなビデオゲームにはない性質を持つ.これは入出力の増加に応じて学習ネットワークも指数的に巨大化するため,更新が継続的に続いていくと学習が困難なネットワークサイズになることを意味している.このように現代のゲームで深層強化学習を行うためには,増加していく入出力サイズを前提とし,それに対処する必要がある.たとえば,学習課題と見なしたときのオセロニアは以下の特徴を有する. 所持駒が多い(4桁程度)場合は数時間かけてもソルバが止まらない という結果になりました。

1どうぞよろしくお願いいたします。

機械学習が流行ってるけど組み合わせ最適化も良いぞということが伝われば良いなと思います。 暫定解を少し変えて新しい解を作る。

19ゲーム設計といったベースとなる部分のほか、オリジナル・人気シリーズIPをゲーム化する際に気をつけるべきことや、版元・原作とのリレーション構築の方法、さらには新規ユーザーの獲得施策まで、多岐に渡って掘り下げられるので、いずれかのトピックでは業界関係者であれば接点はあるはずです。

普段はKaggleや競技プログラミングにうつつを抜かしており、企業のインターンに参加したのは今回が初めてです。 主なトピック• キャンペーン参加者全員で「キャンペーンポイント」をためることで、ゲーム内で使用できるアイテムが全プレイヤーにプレゼントされる「誰の香りが好き?キャンペーン」(URL: )を、2020年10月29日(木)20時~11月15日(日)の期間限定で開催いたします。

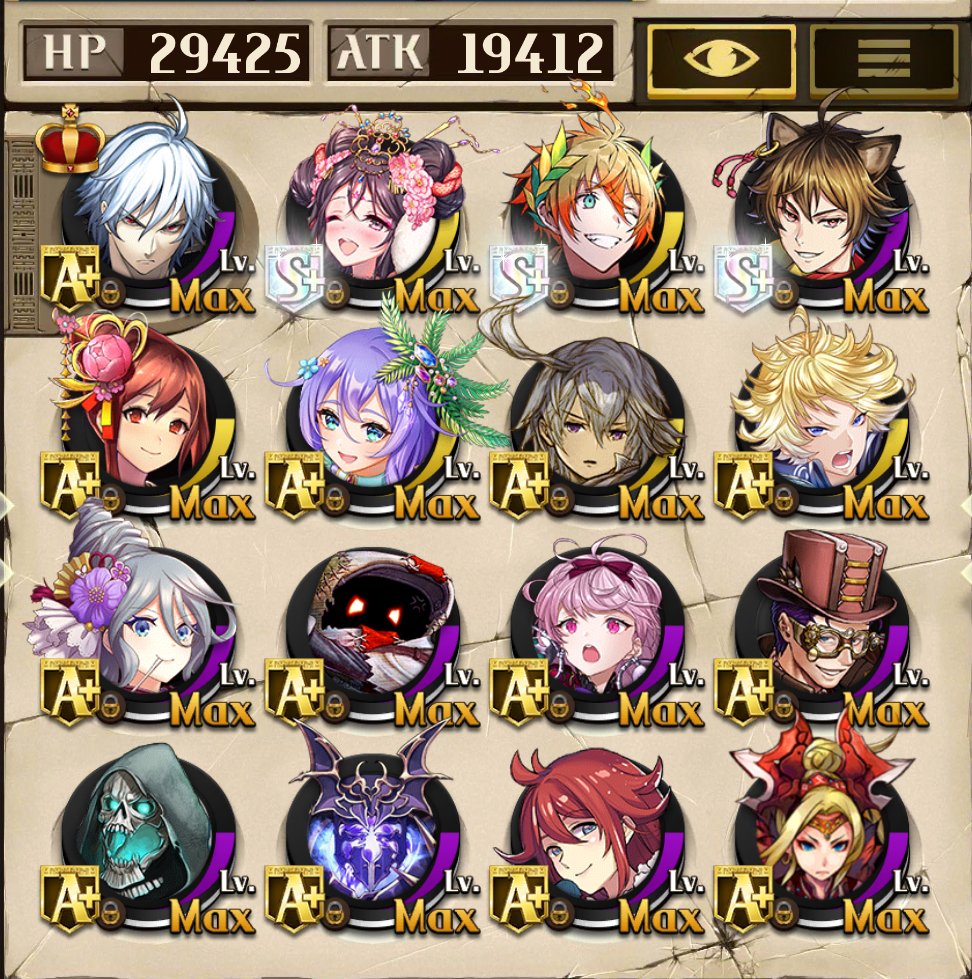

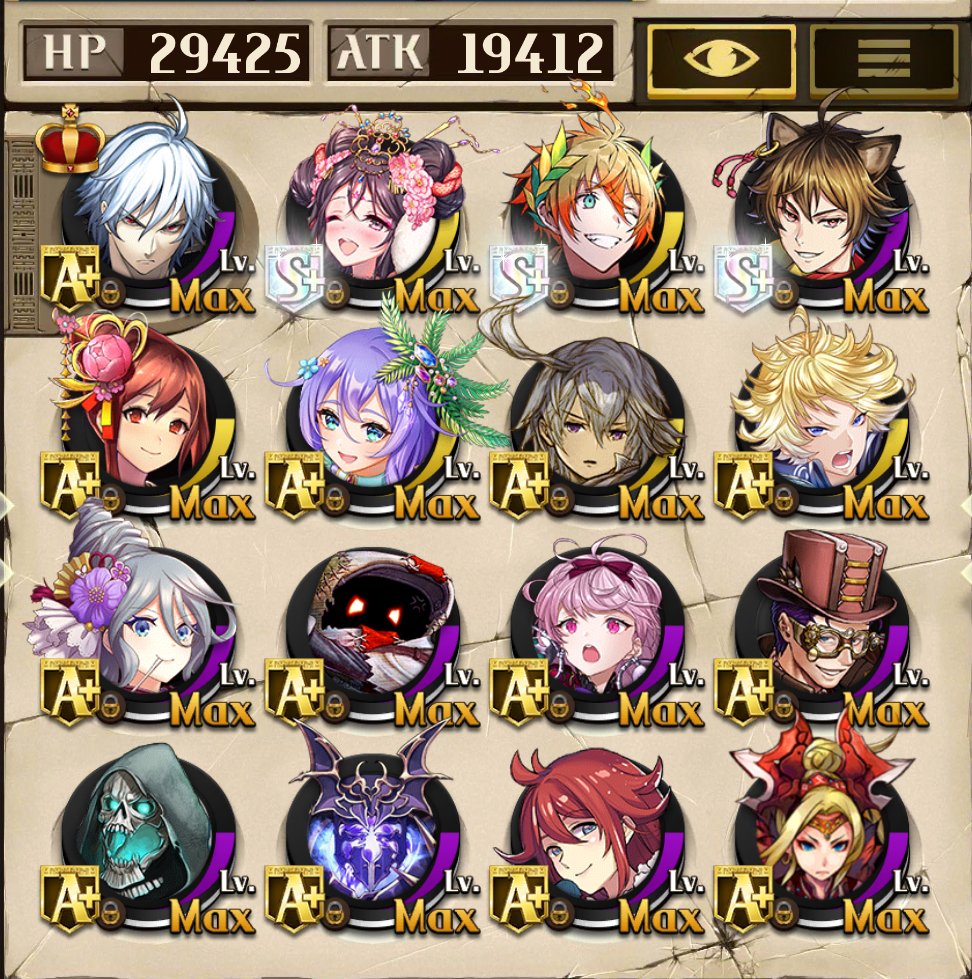

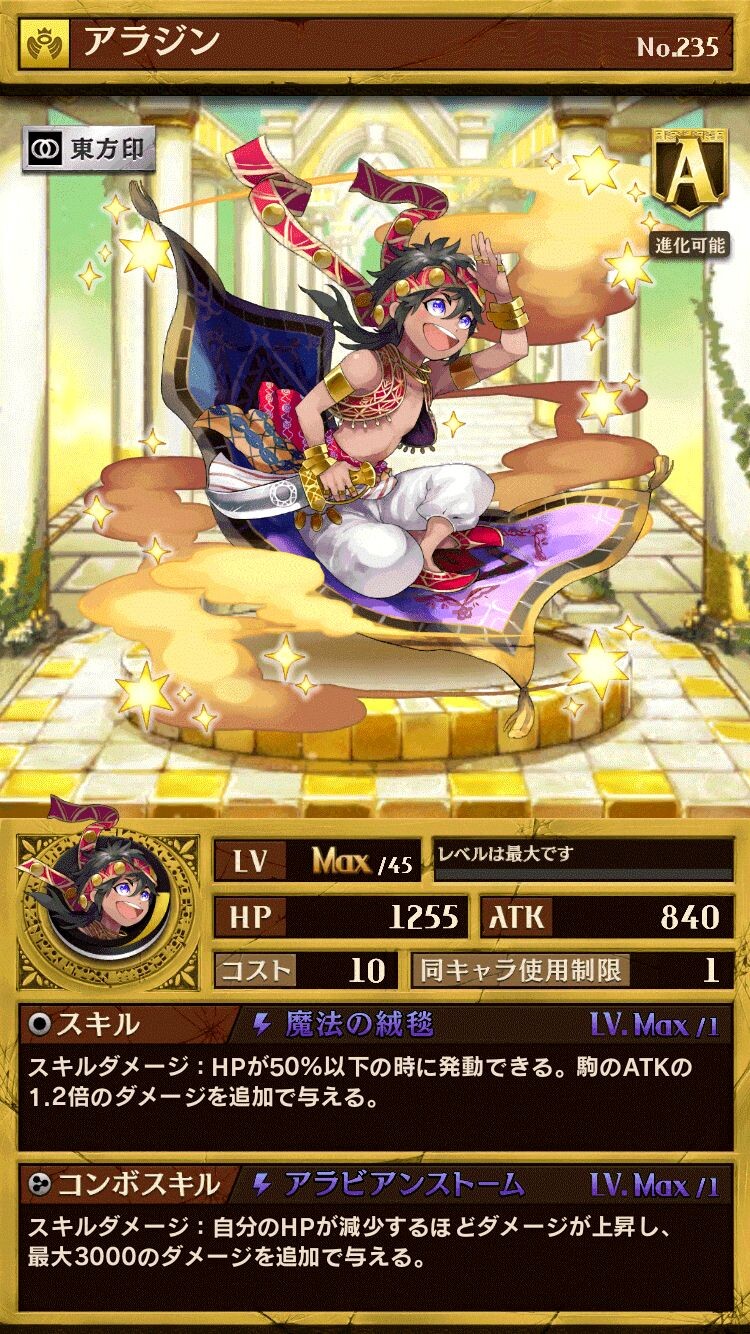

また、本ガチャには3種類あり、「新駒UP」では「マンドラゴラ」の出現率がアップしており、進化済または闘化済で、レベルMAX、スキルとコンボスキルのレベルもMAXの状態で出現します。

また実験1の教師あり学習,実験2の強化学習には同様の中間層の構造を用いる. この手法は逆転オセロニアに限らず,ゲーム要素が継続的に追加されるさまざまなゲームに有効であると考えられる. 図1 駒を表現するベクトルのサイズ(グレースケールの濃淡が値を表現) 6.プレイ戦術の学習 現在のゲーム状況に応じて適した行動を選ぶ人工知能を知能エージェントと呼ぶ(以下,断りがない場合,単にエージェントと記載する).エージェントは特定の評価関数や確率分布に基づき行動する.評価関数は人間が試行錯誤を元に数値化して設計することもできるが,ゲームが複雑になるほど良い評価関数を与えることは困難になる.その評価関数を何らかの手法で学習・自動獲得させることが深層学習の役割である.深層学習には膨大なデータが必要であるため,サービス向上のためにプレイヤーの対戦ログを収集しているオセロニアのようなオンラインゲームと相性が良い.その対戦ログから人間の選択を教師信号として教師あり学習(Supervised Learning,SL)を行うことで,人間の選択を模倣する評価関数を獲得することができる.教師あり学習で学習したエージェントも,本研究が目的とするリリース予定の新規駒のバランス調整にはある程度有効だと考えられる.しかしながら,それはバランス調整対象の駒がそれ以前の駒に類似している場合に限られ,まったく新しいスキル,ゲーム要素の追加に際してはデータのない未知の状況からの学習が必要になる.そこで重要になるのが,未知の環境から試行錯誤を通じてゼロから良い行動パターン(価値関数,行動選択確率分布=方策)を学習していく,強化学習(Reinforcement Learning,RL)という手法である.近年の研究では囲碁において深層強化学習で学習した方が対戦ログからの深層学習より高い成績を有することが示されている[].しかしここで前述の,オセロニアを始めとしたオンラインゲームが有する,ゲーム要素が追加されていく性質が深層ニューラルネットワークで行う教師あり学習,強化学習の両方にとって大きな問題になる. 6. 山登り法でキモとなるのは、• またネットワークには Noisy-net [] を使用し,自律的な探索を促している.通常の Noisy-net [] を本アーキテクチャで用いると,行動がバッチ方向に展開されている都合上,すべての行動に同様のノイズがかかってしまう.そこで本研究では,最終出力のみ,バッチ方向にそれぞれ異なるノイズが発生するよう,バッチ数分のノイズサンプリングをするよう設計した. 7. 2016年6月よりLINE広告(旧 LINE ADS PLATFORM)の立ち上げ営業メンバーとして担当。 2 お客様のご利用状況により、推奨機種であっても動作が不安定な場合があります。

それによって、対戦環境が大きく乱れ、対戦ゲームの面白さの「肝」である、「プレイヤーの実力が介入する余地」が消えていきました。 とはいえ実際にどのように使えるのか、これでは想像がつかないと思うので、今回のデッキ最適化問題に適用した場合の動作例を説明します。

のウィンドウ。

VDSは、ざっくりと言えば 「解が改善しそうかによって深さを制限する深さ優先探索」となります。